研究人员发表了一个修剪算法 使人工智能应用程序运行得更快

随着越来越多的人工智能应用转移到智能手机上,深度学习模型越来越小,以允许应用运行得更快并节省电池电量。现在,麻省理工学院的研究人员有了一种新的更好的压缩模型的方法。

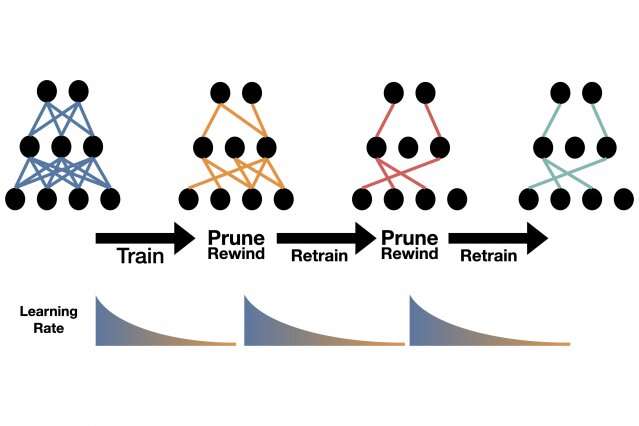

很简单,他们在上个月的一条推文中发布了它:训练模型,修剪它最弱的连接,以快速的早期训练速率重新训练它,然后重复它,直到模型达到您想要的大小。

“就是这样,”亚历克斯伦达博士说。麻省理工学院的一名学生。修剪模型的标准操作非常复杂。"

伦达在本月远程举行的国际学习大会(ICLR)上讨论了这项技术。伦达是麻省理工学院电气工程和计算机科学系(EECS)的学生,也是计算机科学和人工科学实验室成员、电气工程和计算机科学助理教授迈克尔卡平。

去年,在ICLR,Frankle和Carbin关于彩票假说的获奖论文寻求更好的压缩技术。他们表明,如果在训练的早期阶段找到了正确的子网,深度神经网络只能执行十分之一的连接。随着计算能力和训练更深层次学习模型的能量需求的指数级增长,这一启示一直延续至今。这种增长的成本包括全球变暖碳排放的增加和创新潜力的下降,因为不是大型科技公司的研究人员争夺稀缺的计算资源。每天用户也会受到影响。大型AI机型会消耗手机的带宽和电池电量。

彩票假说引发了一系列的理论后续论文。但在同事的建议下,Frankler决定看看它可能会修剪哪些课程,其中搜索算法将修剪搜索树中评估的节点数量。这个领域已经存在了几十年,但在ImageNet竞赛中神经网络在图像分类上取得突破性成功后又重新出现。随着模型变得越来越大,研究人员添加了多层人工神经元来提高它们的性能,而其他人则提出了减少它们的技术。

现在是麻省理工学院助理教授的宋涵就是一个先驱。在一系列有影响的论文的基础上,韩提出了一种剪枝算法,他称之为AMC或AutoML,用于模型压缩,这仍然是行业标准。在韩的技术下,冗余的神经元和连接被自动删除,模型被重新训练以恢复其初始精度。

针对韩的工作,Frankle最近在一篇未发表的论文中建议,通过将较小的修剪模型反转到其初始参数或权重,并以更快的初始速率重新训练较小的模型,可以进一步改善结果。

在目前的ICLR研究中,研究人员认识到,这种模型可以简单地回归到其早期训练速度,而无需修改任何参数。在任何修剪方案中,模型越小,精度越低。然而,当研究人员将这种新方法与韩的AMC或Frankle的重绕方法进行比较时,无论模型缩小多少,效果都更好。

目前还不清楚为什么修剪技术效果这么好。研究人员表示,他们将把这个问题留给其他人来回答。研究人员表示,对于那些想尝试的人来说,这种算法和其他修剪方法一样容易实现,而且不需要时间来调整。

“这是‘Book’中的剪枝算法,”Frankle说。“这是显而易见的,普遍的,简单的。”

对韩来说,从一开始就把重点从压缩AI模型转移到引导AI,从而设计出一个小而高效的模型。他的最新方法“为所有人做”也在ICLR首次亮相。关于新的学习率方法,他说:“我很高兴看到新的修剪和再培训技术继续发展,使更多的人能够使用高性能的AI应用程序。”

免责声明:本文为转载,非本网原创内容,不代表本网观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。

最新文章

- DNF搬砖最佳宠物搭配指南

- DNF白金徽章变现攻略:如何巧妙出售白金徽章

- 寒潮蓝色预警:近两日最低气温 0℃线南压至江南南部至贵州南部和云南北部一带

- DNA 纳米机器人:可改造人造细胞,推动合成生物学发展

- 新型巨型里德伯原子成为精准量子温度计

- 《生化危机9》重大爆料:里昂确定回归主角,吉尔缺席引热议

- 广东:到 2027 年 绿色低碳循环经济体系基本建成

- 2024 财年美国对外军售额创历史新高:背后的战略与影响

- 离子阱量子计算在近年实现双码纠错

- 这次与肯德基的全新联动,星铁再次硬控玩家热情?

- 新年多城土地市场回温:杭州单价地王纪录 3 个月内两度被打破,民企恢复拿地

- 扎克·克雷格执导新版《生化危机》电影,发行权引多家大公司激烈争夺

- 广东:积极推进煤炭消费控制,全力构建以新能源为主体的新型电力系统

- 广东:到 2027 年,全力构建绿色低碳循环经济体系

- 长三角铁路春运再创佳绩:昨日发送旅客 310.2 万人次

- 海通策略:2025 年政策见效下市场望步入基本面驱动新阶段,结构上科技制造确定性更强

- 《最终幻想14》水晶世界青魔法师职业任务全攻略

- 上海:推出乡村振兴领域优秀博士后创新计划,打造高潜力创新人才‘储备库’

- 春节机票价格跳水至百元,航司退差价政策各异引关注

- 浙江:到 2030 年,LNG 年接收能力达 4250 万吨

- 上海:启动乡村振兴博士后创新计划,打造高潜力人才‘蓄水池’

- 币界网晚讯速递:SHIB币价攀升至0.00002044美元,日内涨幅达2.10%

- 不知火舞《街霸6》惊艳换衣秀,细节之处尽显匠心,玩家为之痴狂

- 中国汽车:奋力争夺超豪华市场入场券